Un experimento con dos millones de personas ha planteado cómo debería actuar un vehículo sin conductor ante un incidente de tráfico con consecuencias mortales. Lo leemos de Miguel Ángel Criado en elpais.com.

Dilema 1: Un coche sin conductor se queda sin frenos llegando a un paso de cebra. Si sigue recto atropella a dos peatones, si da el volantazo se lleva por delante a un gato. Dilema 2: El vehículo se encuentra en el paso a un ejecutivo trajeado y, si gira, a un indigente. El choque matará a uno de ellos. Dilema 3: A bordo del automóvil van una mujer embarazada y su hija, enfrente tres ancianos que solo puede evitar yendo contra un muro. ¿A quién salvarías? Un experimento con millones de personas muestra ahora cómo debería ser la moral que guíe a los vehículos conectados en un accidente. Sus resultados son una medida de la propia moral humana.

Ya hay infinidad de ensayos con coches que se conducen solos, ha habido hasta atropellos mortales y es cuestión de tiempo que los vehículos autónomos circulen de forma habitual por las carreteras. Un informe de Intel, por ejemplo, indica que serán mayoría en unas décadas. Al retirar de la ecuación la imprudencia y errores humanos, prometen reducir los accidentes. Pero habrá situaciones en las que un fallo mecánico, el tiempo o las condiciones de la carretera hagan inevitable el accidente. En esos casos las máquinas deberán decidir entre dos males y para ello habrá que dotarlas de unos principios morales.

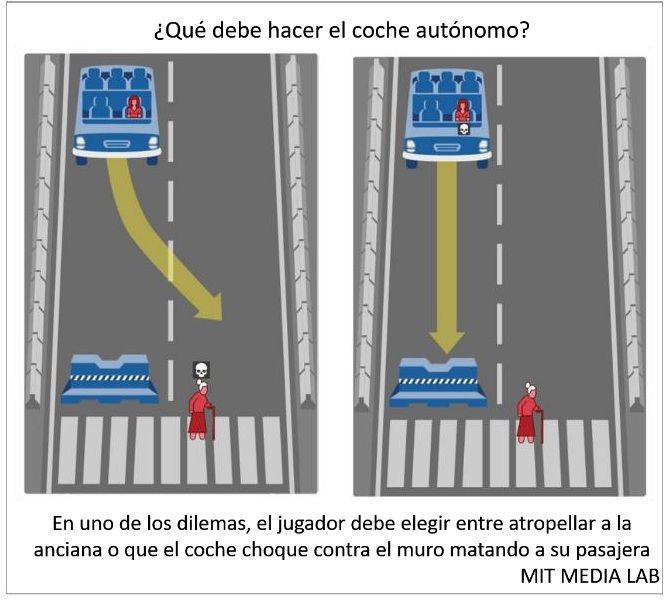

Buscando esos principios, un grupo de científicos europeos y estadounidenses diseñaron un videojuego (un serious game), en el que los participantes tenían que hacer de coche autónomo. Se les presentaron una decena de dilemas como los de arriba en los que alguien moría sí o sí, ya fueran los ocupantes del coche o diversos peatones, desde una persona obesa hasta tres viejecitas, pasando por alguien que cruzaba la calzada por donde no debía.

Salvar a las personas sobre los animales, cuantas más personas mejor y a los niños sobre los ancianos son las decisiones mayoritarias.

En el experimento de la máquina moral, como la han llamado, han participado ya más de dos millones de personas de 233 países y territorios. Con sus casi 40 millones de dilemas resueltos, se ha convertido en una especie de tratado sobre lo que los humanos creen que es más o menos correcto.

“Vimos que hay tres elementos que las personas tienden a aprobar más”, dice el investigador del Media Lab del Instituto de Tecnología de Massachusetts (MIT) y principal autor del estudio, Edmond Awad. Primero, entre salvar a un humano o un animal, el coche siempre debería atropellar a la mascota. La norma, además, primaría salvar al mayor número de personas. Así que si el conductor va solo y va a atropellar a dos peatones, que se estampe contra el muro. La tercera decisión más universal es que la mayoría cree que si un vehículo autónomo tiene que decidir entre chocar contra un niño o contra un anciano, el viejo debe morir para que el niño tenga la oportunidad de crecer y envejecer.

Aparte de estas tres decisiones morales que son casi universales, la investigación, publicada en Nature, muestra una preferencia específica según el tipo de personaje: De los que cruzan el paso de cebra, los que merecen más la pena salvar son, por este orden, un bebé a bordo de un carrito, una niña, un niño y una mujer embarazada. En sentido contrario, y dejando a un lado las mascotas, los delincuentes, los ancianos y los sintecho son los humanos más sacrificables.

Esta predilección por unas vidas sobre otras introduce un elemento que discrimina a las personas por sus características personales, apuntando a la desigualdad en la moral de las máquinas. “Las comparaciones no implican que los expertos deban cambiar sus normas para complacer a la gente. Lo que sugerimos es que las tengan en cuentan, ya que les ayudarán a anticipar la reacción pública a las diferentes regulaciones que redacten”, comenta Awad.

Diferencias según la nacionalidad

Además de resolver dilemas, medio millón de jugadores rellenaron una encuesta con datos personales como edad, género, ingresos, educación, posición política y creencias religiosas. Los investigadores buscaban con ello algún rasgo personal que modulara los dilemas morales. Salvo la religiosidad, ningún otro factor parece influir a la hora de decidir a quién salvar. Pero aquí acaba el sueño de una moral universal.

Gracias a la geolocalización, el estudio pudo determinar el origen de los participantes, detectando marcadas diferencias regionales. Así, aunque las ancianas son las menos salvadas de entre los humanos

Gracias a la geolocalización, el estudio pudo determinar el origen de los participantes, detectando marcadas diferencias regionales. Así, aunque las ancianas son las menos salvadas de entre los humanos

solo por detrás de los delincuentes, los asiáticos tienden a salvarlas más que los occidentales. En Europa y EE UU hay una predilección sutil pero significativa por las personas de complexión atlética sobre los obesos. En los países del sur, tienden a salvar más a las mujeres sobre los hombres. Y en las naciones más desiguales, un porcentaje mayor de los participantes prefirió salvar al peatón con aspecto de ejecutivo.

“Nuestros resultados sugieren que implantar un único conjunto de normas en todos los países sería complicado”, opina el investigador del MIT. “La misma norma aplicada en diferentes lugares podría recibir distinto apoyo social en los distintos países”, añade. En la investigación ponen un ejemplo: entre los principios que regirían la toma de decisiones del coche, un algoritmo podría favorecer por

norma a los peatones sobre un único conductor. Pero ¿y si esos peatones cruzan de forma indebida?

El único país que ha propuesto ya una guía moral para los vehículos autónomos es Alemania. En el verano de 2017 y a instancias del Ministerio de Transportes, un grupo de ingenieros, profesores de filosofía, expertos en derecho, representantes de los fabricantes, los consumidores y hasta las iglesias elaboraron un código ético con 20 normas. La mayoría no chocan con los resultados de este estudio. Pero sí lo hace su ambición de ser universalmente válidas. Pero hay un choque frontal con la norma ética nº 9, que dice lo siguiente: “En el caso de situaciones donde el accidente sea inevitable, está estrictamente prohibida cualquier distinción basada en rasgos personales (edad, género, o constitución física o mental).

Uno de los autores de este código es el profesor de Filosofía de la Universidad Técnica de Múnich Christoph Lütge. Para él, la igualdad debería mantenerse. “Tanto por razones legales como éticas, la programación no puede tratar de forma diferente a las personas con rasgos personales distintos. Sé que hay quienes dicen que hay experimentos que muestran que instintivamente favoreceríamos al niño. Pero eso no se puede convertir en una norma para una máquina. La ética no siempre puede seguir los instintos”.

Fuente: http://www.asepa.es/

Antonio Mozas

Antonio Mozas

Director de ASEPA (Asociación Española de Profesionales de Automoción)

REDUCE LOS COSTES DE LA FLOTA CON NUESTRO PROGRAMA DE AUDITORÍA

La auditoria es una herramienta clave para conocer el estado general y suministrar el análisis, la evaluación, la asesoría, las recomendaciones y las acciones a realizar con el objetivo de reducir costes e incrementar la eficacia y la eficiencia de la gestión de la flota. Conoce nuestro programa de auditoría.